Ein seit mehr als 50 Jahren bekanntes Geschäftsmodell erlangt durch die Möglichkeiten der Digitalisierung mit einem Mal ein komplett neues Gewicht und hat weltweit bereits mehr als 50 % aller Fertigungsunternehmen dazu gebracht, ihr Geschäftsmodell zu überdenken und teilweise sogar vollkommen umzukrempeln. Die Rede ist von „Servitization“. Doch was ist das und wem nützt es wirklich?

Was ist Servitization?

„Servitization ist eine Geschäftsmodellinnovation, die für produzierende Unternehmen relevant ist und die Änderung des bisherigen Angebotsportfolios weg von nur Sachgütern und hin zu einer Kombination aus Sachgütern und Dienstleistungen bezeichnet. Damit spiegelt sie den gesamtwirtschaftlichen Trend zur Dienstleistungsgesellschaft auf Unternehmensebene wider.“ – Wikipedia

Anders gesagt: Hersteller ergänzen ihre Produkte durch Services oder tauschen diese sogar komplett damit aus. Dabei sind viele unterschiedliche individuelle Implementierungen möglich und es lassen sich drei grundsätzliche Service-Typen unterscheiden: Base Services, Intermediate Services und Advanced Services. [1]

- Base Services sind solche Dienstleistungen, die zusätzlich zur Produktbereitstellung kommen. Dies ist in der Regel eine Bereitstellung von zusätzlichen zugehörigen Produkten, wie zum Beispiel Ersatzteile.

- Intermediate Services dienen dazu, die Funktion eines Produktes und dessen Leistungsfähigkeit zu garantieren, beispielsweise durch Überwachung des Betriebs und präventive Wartungsarbeiten.

- Advanced Services bedeuten, dass ein Kunde kein physisches Produkt, sondern anstelle dessen eine Leistung erwirbt und pro solch einer erbrachten Leistung bezahlt. Es findet hier vermehrt kein Eigentumswechsel des Produktes statt. Denkbar sind hier viele verschiedene Möglichkeiten.

Ein bekanntes und oft zitiertes Beispiel für die Anwendung eines Advanced Service, bietet der Triebwerkhersteller Bristol Siddeley. Dieser hat mit dem „Power-by-the Hour“-Modell bereits in den 1960er Jahren ein Servitization-Modell eingeführt. Nachdem Bristol Siddeley 1968 von Rolls Royce gekauft wurde, wurde das Konzept aufgegriffen, ausgebaut und seitdem als Service namens TotalCare bis heute angeboten.

Dabei geht es darum, die Triebwerke für Flugzeuge nicht mehr im klassischen Sinne an den Flugzeugbauer zu verkaufen. Der Flugzeugbauer bezahlt lediglich für die tatsächlichen Betriebsstunden des Triebwerks. Das Gerät bleibt dabei vollständig Eigentum von Rolls Royce, die sich dann auch um Wartung und Reparatur kümmern. Rolls-Royce war es so möglich, die Erlösströme zu stabilisieren und höhere Umsätze zu erzielen. Gleichzeitig bietet es dem Kunden wiederum planbare Betriebskosten, reduzierte finanzielle Risiken und ein effizienteres und zuverlässigeres Produkt.

Servitization findet aber auch vereinzelt in anderen Branchen Anwendung. Während Beispiele wie die Betreuung einer Maschine durch den Hersteller relativ naheliegend sind, findet man Servitization auch immer häufiger in zunächst unüblich erscheinenden Bereichen. So hat zum Beispiel das schwedische Bauunternehmen Skanska ein Krankenhaus gebaut und ist nun im Anschluss auch der Betreiber des Krankenhauses.

Ein Servitization Potenzial liegt für einen Hersteller meistens dann vor, wenn die Service-Angebote außerhalb der Kernkompetenz des Kunden liegen. Es entsteht durch sie also zusätzlicher Aufwand und Kosten und somit kein Gewinn für den Kunden.

Vorteile durch Servitization

Für Hersteller und Kunden bietet Servitization einen gemeinsamen Fokus auf den reibungslosen Betrieb. Es ergibt sich für Hersteller und Kunde eine Angleichung der Anforderungen an das Produkt. Für Kunden steht in der Regel ein möglichst effizientes und langlebiges Produkt im Vordergrund. Der Hersteller verdient allerdings unter Umständen mehr an seinem Produkt, wenn es gegen Abrechnung repariert wird oder wenn aufgrund eines Defektes ein neues (Austausch-) Produkt verkauft werden kann. Durch Servitization entsteht nun ein Zustand, indem sowohl für den Kunden, als auch den Hersteller, ein wartungsarmes Produkt den größten finanziellen als auch wirtschaftlichen Nutzen bietet.

Da der Hersteller nun auch z.B. für die Wartung zuständig ist, werden für ihn die Bedürfnisse des Kunden deutlich relevanter. Je zuverlässiger und wartungsärmer das Produkt, um so besser für den Hersteller, da jetzt weniger Wartungsarbeiten ausgeführt werden müssen und mehr Betriebsstunden abgerechnet werden können. Überspitzt könnte man sagen, dass theoretisch betrachtet der Hersteller selber die Rolle übernimmt, die bisher sein Kunde eingenommen hatte. Wenn so die Effizienz und Langlebigkeit von Produkten verbessert werden kann, wird im selben Moment der Betrieb automatisch ressourcenschonender und nachhaltiger.

Darüber hinaus kann man Mithilfe eines Servitization-Modells die Beziehung zu Kunden festigen und vertiefen und es ist einem Unternehmen möglich, sich von seinen Mitbewerbern durch mehr als nur die Produktqualität und den Preis zu differenzieren. Ein Lieferant von Sachgütern lässt sich schneller austauschen, als eine enge Zusammenarbeit mit einem Kunden. Außerdem lässt sich so bei einem Kunden der Ausschluss eines Mitbewerbers erzielen.

Natürlich wirkt sich ein Servitization-Modell auch auf den Umsatz aus. So lässt sich durch Service-Angebote beispielsweise ein stetiger Erlösstrom bilden und damit die Erlöse stabilisieren.

Durch die Positionierung als Dienstleister am Markt, kann zusätzlich auch die Wettbewerbsfähigkeit für die Zukunft gesichert werden.

Wann ist Servitization für mich lohnenswert?

Als Hersteller ist es zunächst wichtig zu erkennen, ob Servitization Potential vorhanden ist und worin es liegt. Es gilt herauszufinden, welche Aufgaben ein Produkt bei einem Kunden auslöst und welche dieser Aufgaben der Hersteller selbst bewältigen kann. Diese Aufgaben bilden typischerweise immer dann ein geeignetes Servitization Potential, wenn sie außerhalb der Kernkompetenzen des Kunden aber innerhalb der Kernkompetenzen des Herstellers liegen.

Ein typisches Beispiel wäre hier wieder die Wartung von Maschinen. Wer, wenn nicht der Hersteller selber weiß am besten, wie sich seine Maschinen verhalten sollten und wie sie optimal zu warten sind. Darüber hinaus können aber auch andere Bereiche wie der Betrieb, die Installation oder viele weitere individuelle Vorgänge ein Servitization Potential bergen. Wenn erkannt wurde, in welchen Bereichen Servitization Potential vorhanden ist, sollte geprüft werden ob dies einen wirtschaftlichen Nutzen bietet. Hierfür gibt es verschiedene Anhaltspunkte, z.B.

Wie viele bereits in Betrieb befindliche Einheiten gibt es pro neu Verkaufter Einheit? Je mehr Einheiten sich bereits im Betrieb befinden, um so sinnvoller ist es, mit diesen Geschäfte zu machen, statt sich auf die Geschäfte mit neuen Einheiten zu konzentrieren.

Wie ist das Verhältnis der Kosten über die gesamte Produktlebenszeit zu den Anschaffungskosten für den Kunden? Je höher dieses Verhältnis ist, um so lohnenswerter ist das Service-Geschäft.

Weniger Lohnenswert ist eine Dienstleistung zum Beispiel dann, wenn ein Lieferant oder Hersteller im Produktgeschäft zum Beispiel durch Patente oder besondere Technologien sehr stark ist.

So individuell Service Angebote sein können, so unterschiedlich lässt sich auch die Wirtschaftlichkeit eines solchen Service-Angebots ermitteln. Im Endeffekt sollte jeder einzelne Fall separat geprüft werden.

Wie gestaltet man einen effizienten Service?

Servitization ist – wie am Rolls Royce Beispiel zu sehen ist – nicht nur durch die fortschreitende Digitalisierung entstanden. Aber die Digitalisierung bietet neue Möglichkeiten, ein Servitization-Modell immer optimaler umzusetzen.

Denn der Servitization Ansatz profitiert von den gleichen oder zumindest von vergleichbaren Technologien, die auch verschiedenen IoT-Anwendungen oder der Industrie 4.0 zugrunde liegen: Sammlung, Übermittlung, Speicherung und Analyse von Daten.

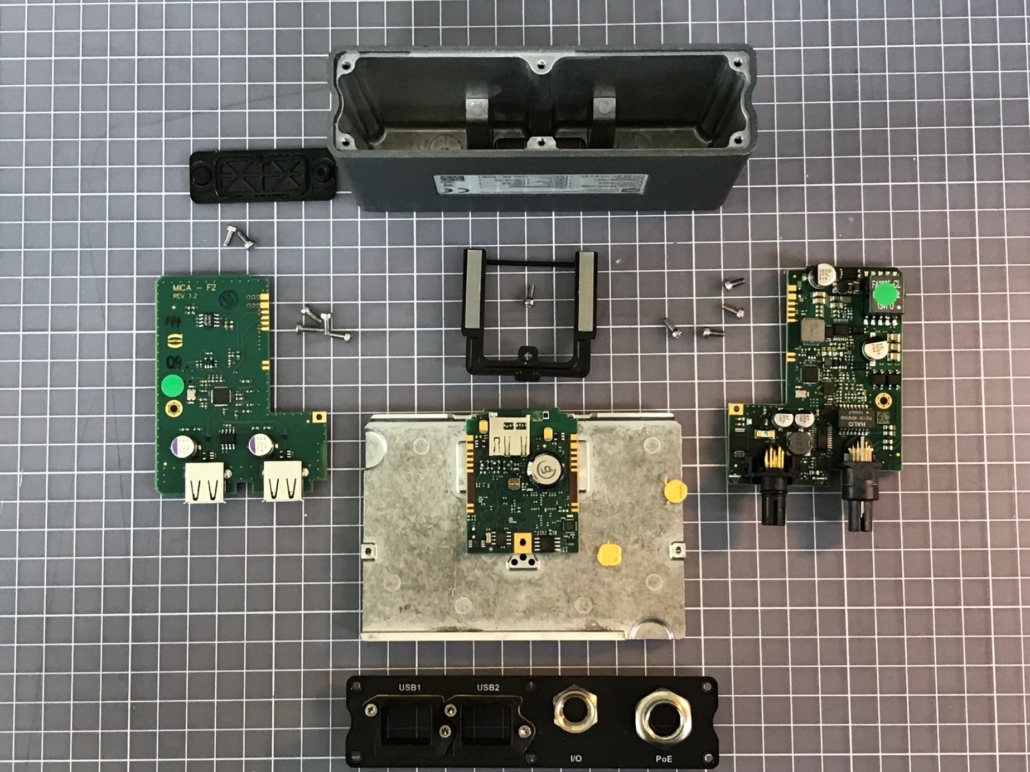

In verschiedenen Bereichen hat die SIC! Software GmbH bereits verschiedenste Sensoren zum Sammeln von Daten eingesetzt und damit ermöglicht, z.B. den Betrieb einer Maschine zu überwachen. Dabei sind verschiedene Möglichkeiten der Analyse denkbar. Ausgelegt auf bloßes Erkennen der Betriebszeit über kleine Änderungen und Abweichungen im Betriebsablauf bis hin zum Erkennen von kompletten Ausfällen.

Bei einer geeigneten Auswertung sind die Daten außerdem dazu geeignet, Wartungsintervalle flexibel auf das tatsächliche Nutzungsverhalten der Maschinen anzupassen. Durch das Überwachen von Verschleißteilen kann ein möglicher Betriebsausfall der Maschine vorhergesagt werden und vorbeugend gehandelt werden („Predictive Maintenance“). So kann die Betriebszeit der Maschine maximiert werden, da unvorhergesehene Ausfälle und Wartungsarbeiten minimiert werden.

Es ist außerdem möglich, das Übermitteln und Visualisieren der Daten in Echtzeit zu realisieren. Über die passende IoT Cloud-Anwendung können die Art der Visualisierung und Alarme individuell konfiguriert und so auf jeden Anwendungsfall abgestimmt werden. Dies ermöglicht in Echtzeit auf Veränderungen im Betriebsablauf zu reagieren, Optimierungen vorzunehmen werden und Daten für weitere Analysen bereitzustellen.

So ist es möglich, eine Abrechnung basierend auf Betriebszeit zu realisieren, vollständig automatisiert Servicetechniker zu Wartungs- und Instandsetzungsarbeiten zu rufen, Verbrauchs- und Verschleißteile automatisch nachzubestellen, eine Rund-um-die-Uhr-Betreuung zu ermöglichen und noch viele weitere denkbare Anwendungsfälle umzusetzen.

Auch über den Einsatz von Servitization-Modellen hinaus birgt die Möglichkeit, Daten über seine Produkte zu sammeln, viele Vorteile. Diese lassen sich unter anderem zur Optimierung der Produkte, Entwicklung von Innovationen und letztendlich auch zur Differenzierung gegenüber Mitbewerbern im Markt einsetzen.

[1] [Baines, Tim & Lightfoot, Howard: Made to Serve: How manufacturers can compete through servitization and product service systems. Wiley, 2013, S. 64–68]